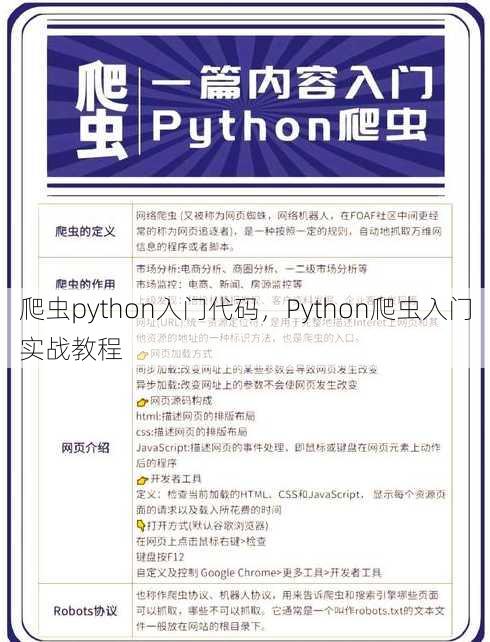

爬虫python入门代码,Python爬虫入门实战教程

为Python爬虫入门代码示例,介绍了如何使用Python编写基础爬虫程序,包括安装必要的库、发送HTTP请求、解析网页内容以及提取所需信息,示例代码展示了如何利用requests库获取网页数据,以及使用BeautifulSoup库进行HTML解析,从而实现对特定网页内容的抓取和提取。

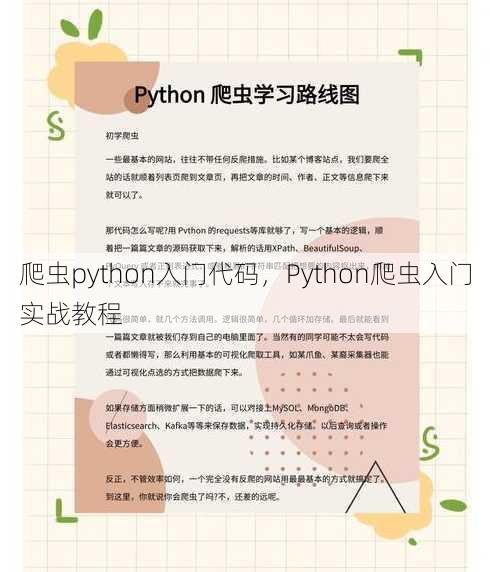

用户提问:我想学习爬虫,Python入门应该从哪里开始呢?

解答:你好!学习Python爬虫是一个很好的选择,它可以帮助你获取网络上的信息,进行数据分析和处理,下面我会从几个来详细介绍Python爬虫的入门代码。

一:Python爬虫基础知识

- 了解爬虫的概念:爬虫是一种自动化程序,用于从网站上抓取信息,它可以帮助我们快速获取大量数据,是数据分析和信息搜集的重要工具。

- 掌握Python基础:在学习爬虫之前,你需要有一定的Python基础,包括基本的语法、数据类型、控制结构等。

- 了解HTTP协议:爬虫是通过发送HTTP请求来获取网页内容的,因此了解HTTP协议的基本原理是非常重要的。

- 学习HTML和XML解析通常是HTML或XML格式,学习如何解析这些格式可以帮助你提取所需的信息。

- 了解正则表达式:正则表达式是处理字符串的强大工具,在爬虫中用于匹配和提取特定模式的数据。

二:选择合适的库

- requests库:requests是一个简单易用的HTTP库,可以用来发送请求、获取响应等。

- BeautifulSoup库:BeautifulSoup是一个用于解析HTML和XML的库,它提供了方便的方法来提取数据。

- lxml库:lxml是一个性能更好的解析库,它提供了快速的解析能力,适合处理大型文档。

- Scrapy框架:Scrapy是一个强大的爬虫框架,可以用来构建复杂的项目。

- Selenium库:Selenium是一个自动化测试工具,也可以用于爬取动态网页内容。

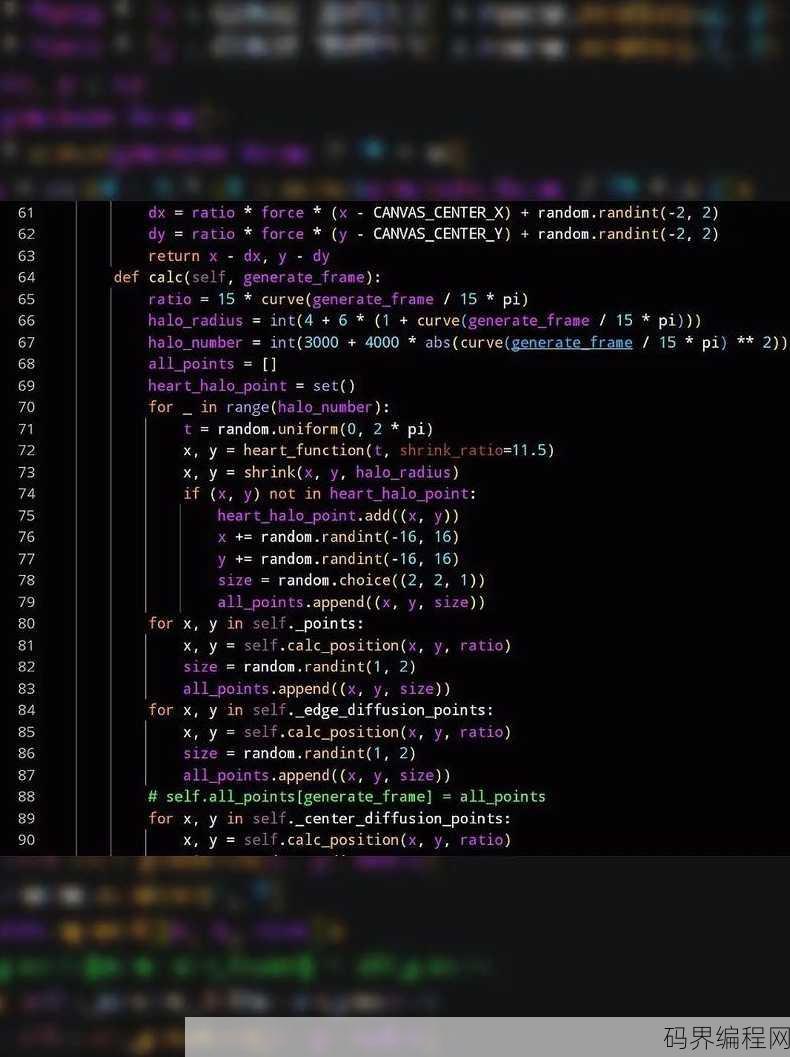

三:编写简单的爬虫代码

- 发送HTTP请求:使用requests库发送GET或POST请求,获取网页内容。

- 解析网页内容:使用BeautifulSoup或lxml库解析获取到的HTML或XML内容。

- 提取所需数据:使用库提供的功能提取所需的数据,如标题、链接、文本等。

- 存储数据:将提取的数据存储到文件或数据库中。

- 错误处理:编写代码时要注意异常处理,确保爬虫在遇到错误时能够正常继续运行。

四:遵循网站规则

- robots.txt:在爬取网站之前,先查看网站的robots.txt文件,了解哪些页面可以爬取。

- 尊重网站版权:不要爬取受版权保护的内容,避免侵犯他人的权益。

- 合理请求频率:避免短时间内对同一网站发送过多请求,以免给网站服务器带来压力。

- 用户代理:设置合适的用户代理,模拟正常用户的访问行为。

- 遵守法律法规:确保你的爬虫行为符合当地的法律法规。

五:进阶技巧

- 分布式爬虫:使用Scrapy-Redis等工具实现分布式爬虫,提高爬取效率。

- 异步爬虫:使用asyncio库实现异步爬虫,提高并发能力。

- 数据清洗:对爬取到的数据进行清洗,去除无效或重复的数据。

- 数据可视化:使用matplotlib、seaborn等库对爬取到的数据进行可视化分析。

- 机器学习:将爬虫与机器学习技术结合,实现更智能的数据分析。

通过以上几个的详细介绍,相信你已经对Python爬虫入门有了基本的了解,实践是学习的关键,多写代码,多尝试不同的方法,你将逐渐成为一名优秀的爬虫工程师,祝你好运!

其他相关扩展阅读资料参考文献:

爬虫Python入门代码详解

爬虫技术简介 爬虫技术是一种通过自动化程序模拟浏览器行为,获取网页数据的技术,Python作为一种功能强大且易于学习的编程语言,广泛应用于爬虫开发领域,本文将介绍Python爬虫的基础知识,并提供入门代码示例。

爬虫Python入门代码一:HTTP请求与响应处理

发送HTTP请求 在进行爬虫开发时,首先需要发送HTTP请求获取网页数据,Python中的requests库可以方便地实现HTTP请求的发送,以下是发送GET请求的示例代码:

import requests

response = requests.get('https://www.example.com')

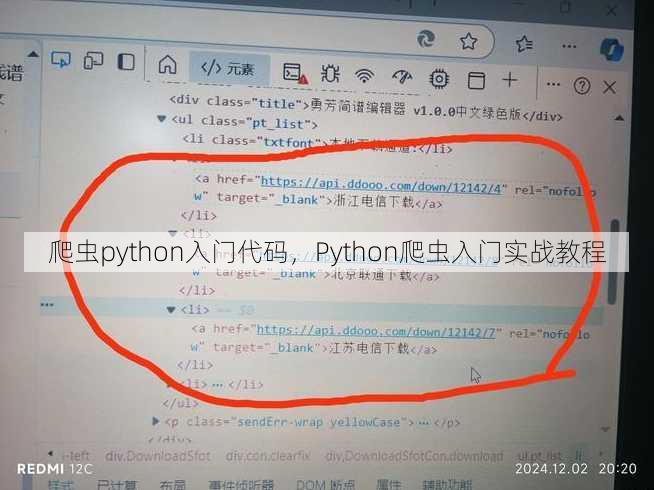

解析HTTP响应 获取到HTTP响应后,需要解析响应内容,常见的响应格式为HTML和JSON,可以使用BeautifulSoup库解析HTML,使用json库解析JSON数据,示例代码如下:

HTML解析:

from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser')

JSON解析:

import json data = json.loads(response.text)

爬虫Python入门代码二:网页数据抓取

选择器定位数据 在网页中,数据通常被包含在特定的标签内,可以使用选择器定位到目标数据,使用BeautifulSoup库中的选择器方法可以选择特定的标签,示例代码如下:

tags = soup.find_all('tag_name') # 替换tag_name为实际标签名

提取数据 定位到目标数据后,可以提取所需的数据,可以使用BeautifulSoup库中的方法提取标签内的文本内容或属性,示例代码如下:

text = tag.text # tag为已定位到的标签对象

提取属性:

attribute = tag.get('attribute_name') # 替换attribute_name为实际属性名

爬虫Python入门代码三:数据存储与持久化

将数据存储到文件 抓取到的数据可以保存到文件中,以便后续处理,可以使用Python的文件操作功能将数据保存到本地文件,示例代码如下:

写入文本文件:

with open('data.txt', 'w') as f:

f.write(data) # data为要保存的数据

数据库存储 对于大量数据,可以使用数据库进行存储和查询,Python中常用的数据库操作库有SQLite、MySQL等,以下是将数据保存到SQLite数据库的示例代码:

连接到SQLite数据库: sqlite3 模块提供了连接SQLite数据库的方法,创建一个数据库文件(如果文件不存在),然后执行SQL命令来创建表并插入数据,示例代码如下: 注意:在实际开发中,请确保已经安装了sqlite3模块。 安装方法:pip install sqlite3 或者通过python自带的sqlite模块进行操作,无需额外安装库。 创建数据库和表: 创建一个数据库文件(如果不存在),然后创建一个表来存储抓取的数据,可以使用SQLite的命令行工具或Python的sqlite3模块来完成这些操作,示例代码如下: 连接到数据库并创建表: import sqlite3 conn = sqlite3.connect('mydatabase.db') c = conn.cursor() c.execute('''CREATE TABLE IF NOT EXISTS mytable (id INTEGER PRIMARY KEY, data TEXT)''') 插入数据到表中: 使用INSERT语句将数据插入到表中,可以使用Python的sqlite3模块执行SQL命令来完成这个任务,示例代码如下: 插入数据到表中: c.execute("INSERT INTO mytable (data) VALUES (?)", (data,)) 提交更改并关闭连接: conn.commit() conn.close() 五、爬虫Python入门代码四:反爬虫策略与应对方法 1.识别反爬虫机制 网站通常会采用各种反爬虫机制来保护自身内容,常见的反爬虫机制包括验证码、访问频率限制等,了解这些机制是编写有效爬虫的关键。 2.使用代理IP 当网站检测到来自同一IP的频繁请求时,可能会阻止该IP的访问,使用代理IP可以有效避免这种情况,可以使用第三方代理IP服务或自己搭建代理服务器,示例代码如下(使用requests库设置代理): 使用代理发送请求: proxy_url = 'http://proxy_ip:port' proxies = {'http': proxy_url, 'https': proxy_url} response = requests.get('https://www.', proxies=proxies) 3.设置合理的请求头 模拟浏览器行为,设置合理的请求头可以绕过一些简单的反爬虫机制,设置User-Agent为常见浏览器的User-Agent,示例代码如下: 设置请求头: headers = {'User-Agent': 'Mozilla/5.0'} response = requests. 本文介绍了Python爬虫入门的基础知识,包括HTTP请求与响应处理、网页数据抓取、数据存储与持久化以及反爬虫策略与应对方法,通过本文的学习,读者可以初步掌握Python爬虫的开发流程和技巧,为后续的深入学习打下基础,在实际开发中,还需要不断积累经验和技巧,以适应不断变化的技术环境。

“爬虫python入门代码,Python爬虫入门实战教程” 的相关文章

ie activex控件官方下载,IE ActiveX控件官方下载地址大全

ie activex控件官方下载提供用户获取官方认证的ActiveX控件,这些控件是Internet Explorer浏览器中用于增强网页功能的插件,用户可以通过官方渠道下载这些控件,以确保安全和兼容性,提升浏览体验,下载过程简单快捷,适用于各种版本的Internet Explorer。ie act...

个人主页asp源码,个性化ASP个人主页源码分享

个人主页ASP源码是指使用Active Server Pages(ASP)技术编写的网页源代码,用于构建动态交互式的个人网站,这些源码通常包含HTML、VBScript或JScript等脚本语言,以及用于数据库交互的ASP内置组件,通过这些源码,用户可以自定义网页设计、实现用户登录、内容管理、留言板...

beanstalk购物,探索Beanstalk购物新体验

Beanstalk购物是一家集时尚、潮流于一体的购物平台,提供各类时尚单品,涵盖服装、鞋包、配饰等,用户可轻松浏览商品,享受便捷的购物体验,平台还定期推出优惠活动,让消费者以更低的价格购买心仪商品,Beanstalk致力于打造一个时尚、轻松的购物环境,让每位用户都能找到属于自己的风格。我的Beans...

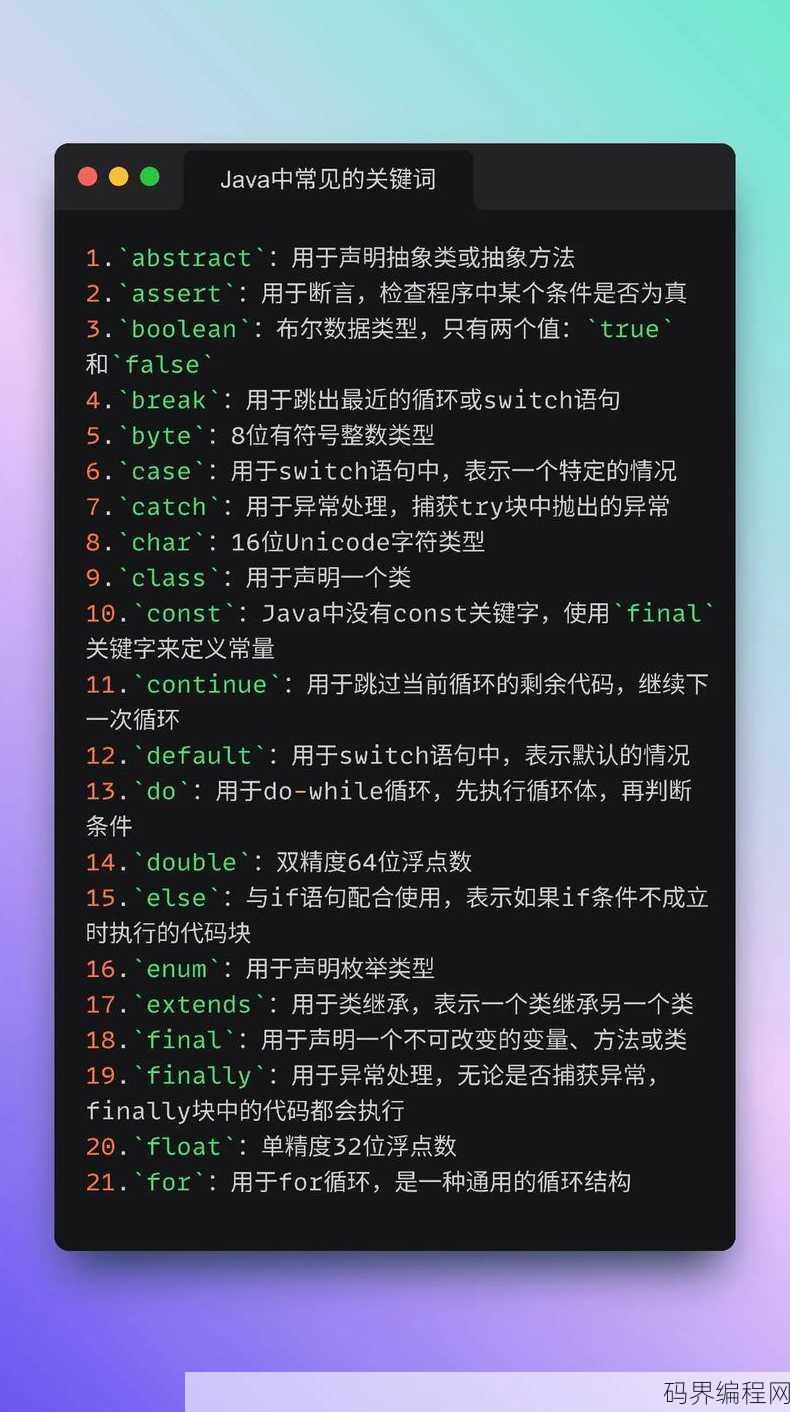

有趣的java代码,Java编程中的趣味代码技巧揭秘

有趣的Java代码通常指的是那些既实用又充满创意的代码片段,它们可能包括:,1. 使用Java内置特性实现巧妙的算法或数据处理。,2. 通过Java API创建有趣的小工具或游戏。,3. 利用Java的图形用户界面(GUI)库制作视觉效果独特或交互性强的应用。,4. 编写简洁的代码实现复杂的逻辑,展...

flash游戏播放器手机版,便携式Flash游戏播放器——手机专用版

Flash游戏播放器手机版是一款专为手机用户设计的应用,允许用户在移动设备上流畅地播放和体验Flash格式的游戏,该应用支持多种设备和操作系统,用户无需安装额外的插件,即可在手机上重温经典Flash游戏,享受便捷的游戏体验。 嗨,我是小明,最近我在手机上玩Flash游戏的时候发现了一个问题,就是有...

javaweb基础知识,Java Web基础知识入门指南

Java Web基础知识涉及Java编程语言在Web开发中的应用,包括Servlet、JSP、JavaBean等技术,它涵盖了HTML、CSS、JavaScript等前端技术,以及Tomcat、Apache等服务器软件的使用,还包括数据库连接和操作(如JDBC),以及MVC设计模式的应用,学习Jav...