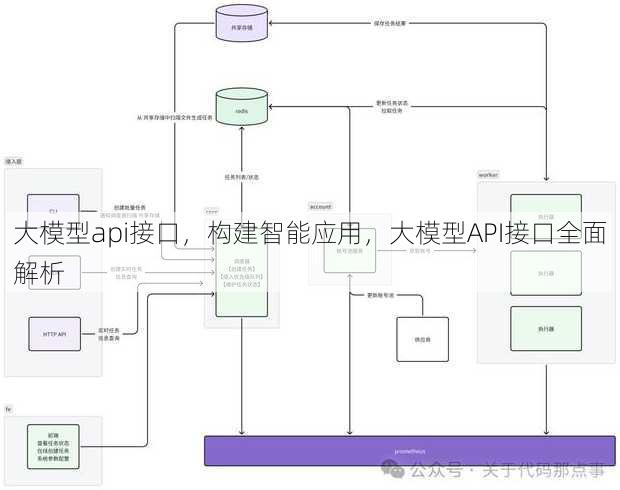

大模型api接口,构建智能应用,大模型API接口全面解析

大模型API接口是一种用于访问大型模型服务的接口,用户可以通过发送HTTP请求,调用API获取模型预测结果,这种接口通常提供多种模型选择,支持多种数据格式,并具备较高的并发处理能力,通过使用大模型API接口,开发者可以轻松地将复杂模型集成到自己的应用中,实现智能化功能。

用户提问:我最近在研究大模型API接口,但感觉这个话题挺复杂的,能简单介绍一下吗?

解答:当然可以,大模型API接口其实就像是一个高级的“快递服务”,它允许开发者将他们的应用程序与强大的预训练模型连接起来,这样,你的应用就可以利用这些模型的能力,比如自然语言处理、图像识别等,而无需自己训练这些复杂的模型,下面我会从几个来详细解释这个概念。

一:什么是大模型API接口?

- 定义:大模型API接口是允许开发者通过网络调用预先训练好的大型模型的服务。

- 作用:简化了模型的使用过程,开发者无需自己训练模型,即可使用模型的能力。

- 优势:节省时间和资源,提高开发效率,降低技术门槛。

- 应用场景:广泛应用于智能客服、内容审核、语音识别等领域。

- 常见模型:如BERT、GPT-3、Inception等。

二:如何使用大模型API接口?

- 注册账号:首先需要在提供API接口的平台注册账号。

- 获取API密钥:注册成功后,平台会提供API密钥,用于后续的接口调用。

- 编写代码:使用API密钥,通过HTTP请求发送数据到模型,并获取处理结果。

- 错误处理:了解常见的错误代码和解决方案,确保API调用的稳定性。

- 性能优化:根据实际需求调整请求参数,提高API调用的效率。

三:大模型API接口的安全性

- 数据加密:确保传输过程中的数据安全,防止泄露。

- 身份验证:使用API密钥进行身份验证,防止未授权访问。

- 访问控制:限制用户对API的访问权限,防止滥用。

- 日志记录:记录API调用日志,便于追踪和审计。

- 合规性:遵守相关法律法规,确保数据处理的合法性。

四:大模型API接口的局限性

- 延迟:网络延迟可能会影响API调用的响应速度。

- 成本:使用大模型API接口可能需要支付一定的费用。

- 模型能力:预训练模型可能无法满足所有特定需求,需要根据实际情况进行调整。

- 数据隐私:在使用API接口时,需要注意数据隐私问题。

- 依赖性:过度依赖API接口可能导致应用的可维护性降低。

五:未来发展趋势

- 模型轻量化:随着技术的发展,大型模型将逐渐向轻量化方向发展。

- 个性化定制:根据用户需求,提供更加个性化的API接口服务。

- 边缘计算:将模型部署在边缘设备上,降低延迟,提高响应速度。

- 开源生态:越来越多的模型和API接口将开源,促进技术发展。

- 跨领域应用:大模型API接口将在更多领域得到应用,推动智能化发展。

通过以上几个的介绍,相信你对大模型API接口有了更深入的了解,希望这篇文章能帮助你更好地理解这个话题。

其他相关扩展阅读资料参考文献:

技术原理

- 模型结构

大模型API接口的核心是基于Transformer架构的深度学习模型,通常包含数百亿参数,通过大规模数据训练形成复杂的语义理解能力,这类模型支持文本生成、问答、翻译等多任务处理,开发者无需了解底层算法即可调用。 - 调用方式

大模型API主要通过RESTful API或gRPC协议实现,用户通过发送HTTP请求或使用高性能通信框架与模型交互,部分平台还提供SDK工具包,简化调用流程并支持多语言开发。 - 性能优化

API接口通常采用异步调用机制,避免阻塞主线程;同时通过缓存机制减少重复计算,模型压缩技术(如量化、蒸馏)降低推理延迟,确保高并发场景下的稳定性。

应用场景

- 行业应用

大模型API已广泛应用于金融、医疗、教育等领域,金融行业用于风险评估和智能客服,医疗行业用于病历分析和药物研发,教育行业用于个性化学习推荐。 - 功能实现

开发者可通过API实现文本生成(如撰写邮件、创作内容)、多语言翻译(支持100+语言)、对话系统(构建智能问答机器人)等核心功能,无需自行训练模型。 - 用户体验

API接口的响应速度直接影响用户体验,优化后的接口可实现毫秒级延迟,通过交互设计(如分步生成、实时反馈)和个性化服务(基于用户历史数据调整输出),提升使用效率。

开发实践

- 接入流程

开发者需先在平台注册账号,获取API密钥,再通过测试环境验证接口功能,调用API时需在请求头中携带密钥,并通过POST方法发送JSON格式的输入数据。 - 调用技巧

合理设置输入参数(如最大输出长度、温度系数)可控制生成结果的多样性;利用并发调用提升处理效率;对错误响应(如超时、参数错误)进行分类处理,确保程序健壮性。 - 成本控制

API调用通常按请求次数或计算资源计费,开发者需通过按需调用策略减少无效请求;使用资源管理工具监控使用量;通过模型压缩或剪枝技术降低计算成本。

安全与合规

- 数据隐私

API接口需通过加密传输(如HTTPS)保护数据安全,同时对用户输入进行匿名化处理,防止敏感信息泄露,部分平台还提供数据脱敏功能,确保符合GDPR等法规。 - 权限管理

采用角色分级系统(如管理员、开发者、访客)限制接口访问权限,通过访问控制列表(ACL)或OAuth2.0认证确保只有授权用户可调用特定功能。 - 法律风险

需注意数据合规性,避免使用受版权保护的内容;部分平台提供内容过滤机制,自动屏蔽违规信息;开发者需签订服务协议,明确责任划分和数据使用范围。

未来趋势

- 技术迭代

随着模型参数量的增加,API接口将支持更复杂的任务(如多模态处理、代码生成)。边缘计算技术的融合将提升本地化推理能力,减少云端依赖。 - 行业渗透

未来API将在更多垂直领域深化应用,例如工业自动化(用于设备故障预测)、法律服务(用于合同分析)等,定制化模型将更受青睐,满足特定场景需求。 - 生态建设

平台将推动API生态发展,提供开源工具和社区支持,降低开发门槛,通过API市场实现模型能力的交易与共享,形成良性竞争环境。

技术挑战与解决方案

- 模型理解偏差

大模型可能因训练数据局限性产生偏见,例如对特定群体的刻板印象,解决方案包括多源数据训练和后处理过滤,确保输出内容中立。 - 资源消耗问题

高并发调用可能导致服务器负载过高,需通过负载均衡和弹性扩容技术优化资源分配,部分平台提供自动伸缩功能,根据流量动态调整计算资源。 - 接口兼容性

不同平台的API设计存在差异,开发者需通过标准化协议(如OpenAPI)或中间件适配解决兼容问题,使用统一的请求格式和响应结构,提升跨平台开发效率。

实际案例分析

- 企业级应用

某电商平台通过大模型API实现智能客服,将用户咨询分类处理,平均响应时间缩短至2秒,利用API的文本生成能力自动生成商品描述,提升运营效率。 - 开发者工具链

开发者可通过API快速构建应用,例如使用Hugging Face的API调用预训练模型,仅需几行代码即可实现文本摘要功能,部分工具链还支持可视化调试,降低开发难度。 - 创新产品开发

某初创公司基于大模型API开发AI写作助手,通过调用API的生成能力帮助用户创作小说和论文,产品上线后用户增长迅速,验证了API在创意领域的潜力。

技术选型建议

- 主流平台对比

需根据需求选择合适平台,例如阿里云适合中文场景,Google Cloud提供多语言支持,AWS具备强大的计算资源,开发者应关注平台的文档完善度和社区活跃度。 - 模型性能评估

调用前需测试模型的推理速度和准确率,例如通过基准测试工具对比不同模型的响应时间,部分平台提供性能监控仪表盘,实时追踪调用效率。 - 成本效益分析

需计算API调用成本与业务价值的平衡点,例如通过免费额度和按需付费模式控制开支,开发者可利用批量处理功能降低单位成本,提升性价比。

技术演进方向

- 轻量化模型

未来API将更多提供轻量化模型(如模型压缩后的版本),降低计算资源需求,适合移动端或嵌入式设备部署。 - 实时交互能力

通过流式处理技术,API可实现对话中的实时生成,例如在用户输入时逐步输出结果,提升交互体验。 - 多模态支持

API将逐步集成图像、音频、视频等多模态处理能力,例如通过上传图片获取描述,或分析语音内容生成文本,拓展应用场景。

技术落地关键

- 明确业务需求

开发者需精准定位使用场景,例如选择API的文本生成功能还是多语言翻译功能,避免资源浪费。 - 数据质量保障

输入数据的准确性直接影响输出结果,需通过数据清洗和预处理提升调用效果,去除噪声文本、标准化输入格式。 - 持续迭代优化

定期根据用户反馈调整API调用策略,例如优化参数设置或升级模型版本,确保技术方案与业务需求同步发展。

大模型API接口作为连接AI技术与实际应用的桥梁,正在重塑各行各业的开发模式。技术原理的深入理解、应用场景的精准匹配、开发实践的高效执行,以及安全与合规的全面保障,共同构成了API落地的核心要素,随着技术的不断演进,开发者需保持对未来趋势的敏感,通过技术选型和落地关键的合理规划,最大化API的价值,无论是企业级应用还是个人创新项目,API接口的成熟度和灵活性都将决定项目的成败。

“大模型api接口,构建智能应用,大模型API接口全面解析” 的相关文章

企业网站php源码免费下载,免费PHP企业网站源码一键下载

本页面提供企业网站PHP源码免费下载服务,用户可轻松获取完整源码,用于搭建或修改企业网站,源码涵盖前端界面和后端逻辑,支持自定义设计,适合有PHP编程基础的开发者使用,立即下载,开始您的企业网站建设之旅。 最近我在网上寻找企业网站PHP源码,想自己动手搭建一个企业网站,网上的资源太多,不知道哪个是...

asp文档管理源码下载,ASP文档管理系统源码免费下载

提供的是关于下载ASP文档管理源码的信息,摘要如下:,“提供ASP文档管理系统的源码下载,适用于需要构建在线文档管理平台的企业或个人,下载后,用户可轻松集成到现有网站中,实现文档的上传、下载、分类和搜索等功能,提高文档管理效率。”ASP文档管理源码下载全攻略:轻松搭建高效文档管理系统 用户解答:...

绝世剑神景言免费阅读,绝世剑神景言,逆天神剑路

《绝世剑神景言》免费阅读,讲述剑神景言在修炼剑道的过程中,历经磨难,凭借过人的智慧和坚韧不拔的意志,一步步踏上巅峰,成为绝世剑神的故事,内容精彩纷呈,充满激情与冒险,读者可免费阅读,感受剑道之美的同时,领略主角的成长历程。 大家好,我最近迷上了一本叫做《绝世剑神景言》的小说,真的是太好看了!我已经...

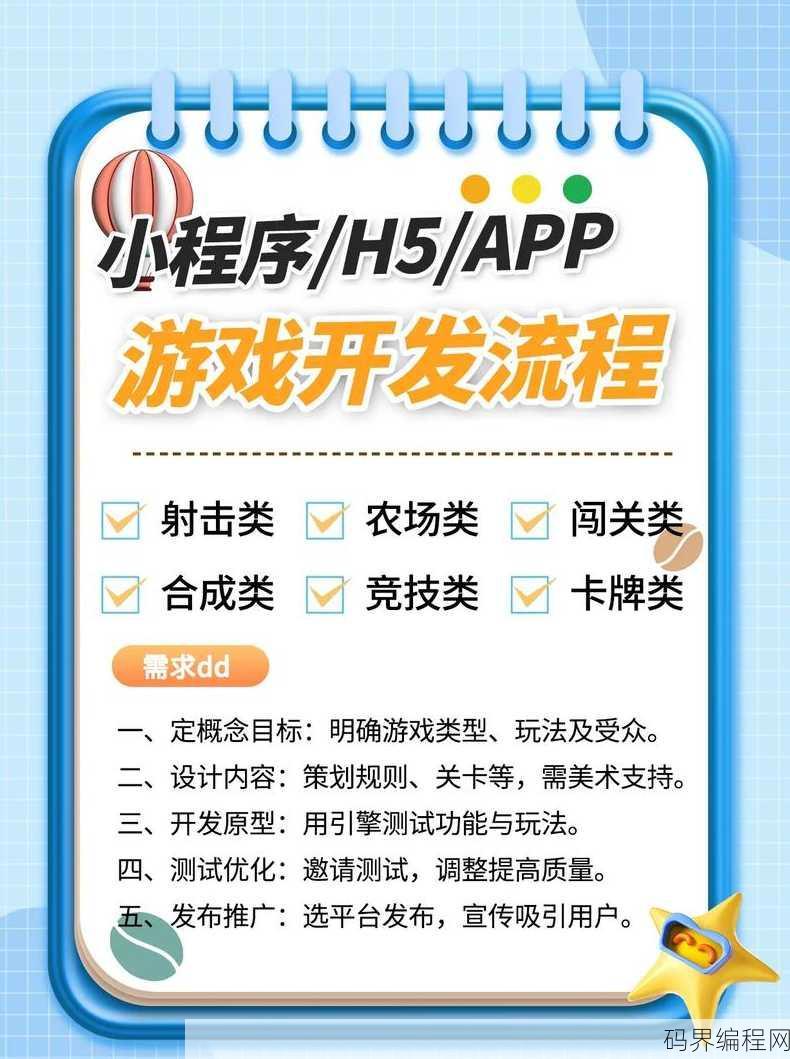

游戏软件怎么制作开发,游戏软件制作与开发全攻略

游戏软件制作开发涉及创意构思、技术实现和用户体验优化,明确游戏类型和目标受众,进行市场调研,设计游戏剧情、角色、场景等元素,制作原型,选择合适的游戏引擎和编程语言进行开发,实现游戏逻辑和交互,优化游戏性能,确保流畅运行,进行测试,收集反馈,不断优化迭代,还需要考虑游戏运营和推广策略,提升游戏市场竞争...

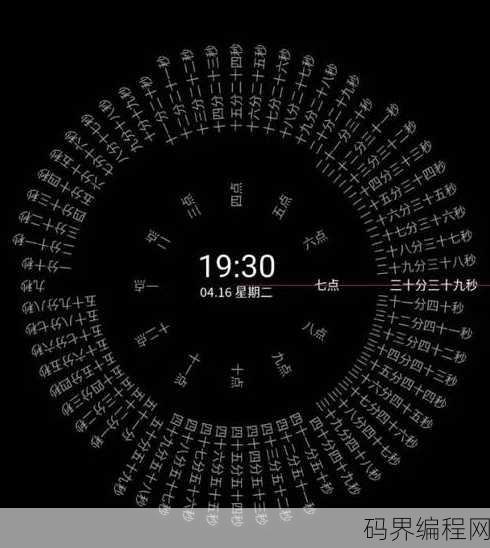

时钟代码大全,全面时钟编程技巧与代码实例集

《时钟代码大全》是一本全面介绍时钟编程技巧和实例的指南,书中涵盖了从基础时钟概念到高级时钟应用的多种编程语言和平台,读者可以通过本书学习到如何实现定时任务、处理时钟中断、以及设计实时系统,书中不仅提供了详尽的代码示例,还包含了对常见问题的解决方法,适合于对时钟编程感兴趣的初学者和专业人士阅读。时钟代...

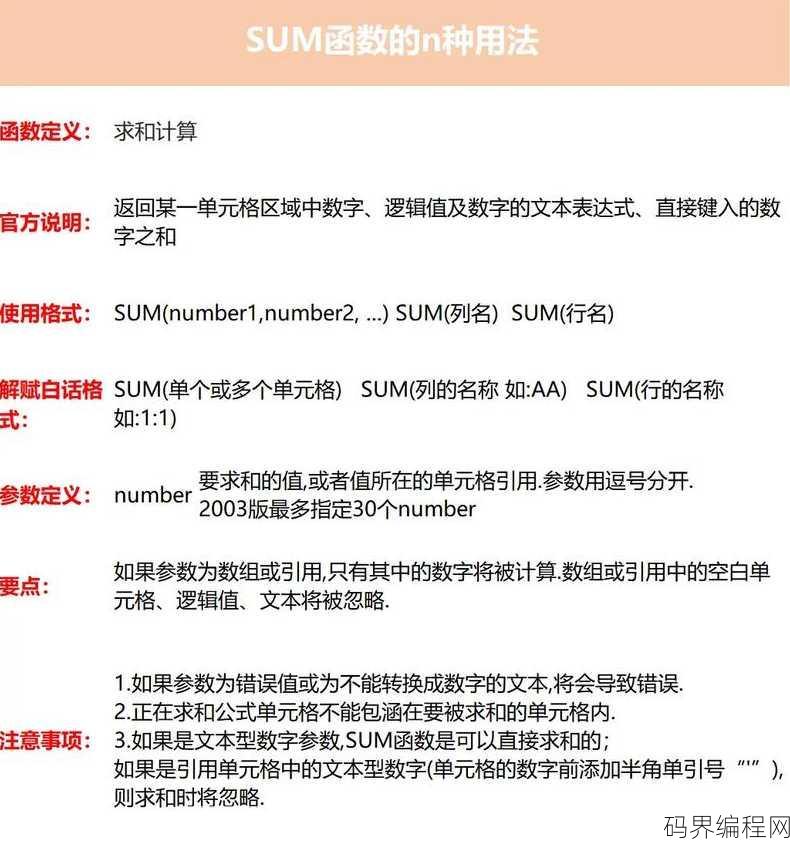

sumproduct和sumifs的区别,Sumproduct与Sumifs函数的区别解析

Sumproduct和Sumifs是Excel中的两个函数,用于计算条件求和,但它们在使用上有显著区别:,Sumproduct函数可以同时进行多条件的交叉乘积求和,适用于多个条件同时满足时计算总和,它需要两个或多个数组作为输入,且每个数组中的条件必须一一对应。,Sumifs函数则适用于对单个数组进行...