python 爬虫,Python爬虫实战技巧与案例分析

Python爬虫是利用Python编程语言编写,用于从互联网上抓取信息的程序,它能够自动访问网站,解析网页内容,提取所需数据,Python爬虫广泛应用于数据挖掘、网络数据分析、搜索引擎等领域,通过使用Python爬虫,开发者可以高效地从网络中获取信息,为各种应用提供数据支持。

Python爬虫:从入门到实践

用户解答: 嗨,大家好!我最近在学习Python,想尝试做一些爬虫项目,但是对Python爬虫这个领域还不是很了解,请问,Python爬虫到底是怎么回事?我需要掌握哪些基础知识呢?

Python爬虫简介 Python爬虫是指使用Python编程语言编写程序,从互联网上自动抓取信息的过程,它可以帮助我们获取网页内容、数据等,是数据分析、信息提取等领域的重要工具。

Python爬虫一:基础知识

- 了解HTTP协议:爬虫程序需要与网站服务器进行交互,因此了解HTTP协议是基础,HTTP协议定义了客户端和服务器之间的通信规则。

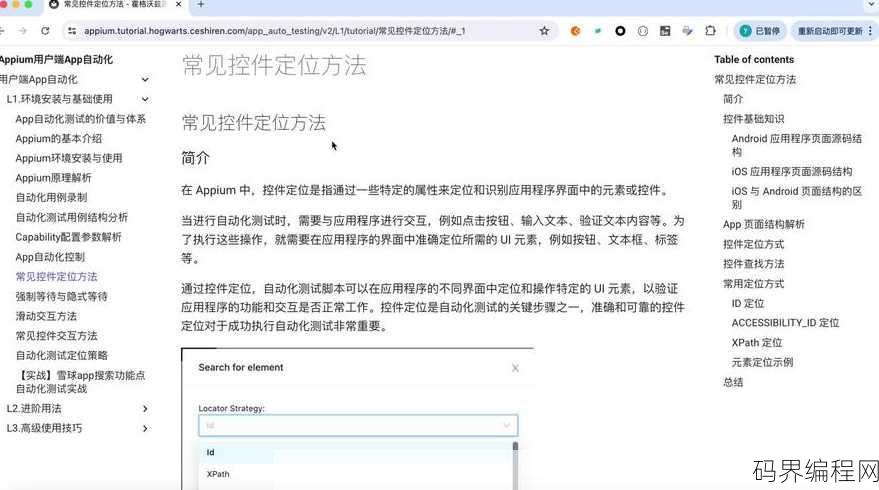

- 掌握HTML解析通常以HTML格式呈现,因此需要学习HTML结构,并使用如BeautifulSoup等库进行解析。

- 学习CSS选择器:CSS选择器可以帮助我们快速定位页面中的元素,是爬虫中常用的技术。

- 了解正则表达式:正则表达式用于匹配和提取字符串,是爬虫中处理非结构化数据的重要工具。

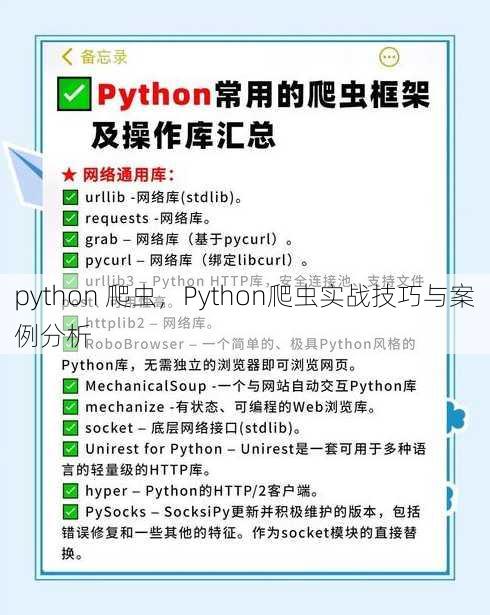

- 熟悉Python库:掌握常用的Python库,如requests、BeautifulSoup、lxml等,这些库可以帮助我们更高效地完成爬虫任务。

Python爬虫二:请求与响应

- 发送HTTP请求:使用requests库发送GET或POST请求,获取网页内容。

- 处理响应:解析响应内容,提取所需信息。

- 异常处理:在爬虫过程中,可能会遇到各种异常,如连接超时、网页结构变化等,需要学会处理这些异常。

- 请求头设置:模拟浏览器行为,设置合适的请求头,避免被网站反爬虫机制识别。

- 代理IP使用:当爬取大量数据时,使用代理IP可以隐藏真实IP,降低被封禁的风险。

Python爬虫三:数据存储

- 选择存储方式:根据需求选择合适的存储方式,如CSV、JSON、数据库等。

- 数据清洗:获取到的数据可能存在重复、错误等问题,需要进行清洗。

- 数据格式转换:将爬取到的数据转换为合适的格式,以便后续处理。

- 数据持久化:将清洗后的数据存储到数据库或文件中,以便后续查询和分析。

- 数据可视化:使用matplotlib、seaborn等库将数据可视化,更直观地展示数据。

Python爬虫四:反爬虫策略

- 识别反爬虫机制:了解常见的反爬虫机制,如IP封禁、验证码、请求频率限制等。

- 绕过验证码:使用OCR技术识别验证码,或寻找无验证码的网站。

- 分布式爬虫:使用Scrapy等框架实现分布式爬虫,提高爬取效率。

- 多线程爬虫:使用多线程技术提高爬取速度,但要注意不要对目标网站造成过大压力。

- 遵守法律法规:在爬取数据时,要遵守相关法律法规,尊重网站版权和用户隐私。

Python爬虫五:项目实战

- 确定目标网站:选择一个合适的网站进行爬取,如新闻网站、电商平台等。

- 分析网站结构:了解目标网站的URL结构、数据存储方式等。

- 编写爬虫程序:根据网站结构编写爬虫程序,实现数据抓取。

- 测试与优化:测试爬虫程序,根据实际情况进行优化。

- 数据分析与应用:对爬取到的数据进行分析,应用于实际项目中。

Python爬虫是一个涉及多个领域的技能,掌握基础知识、了解反爬虫策略、进行项目实战是提高爬虫能力的关键,希望本文能帮助你更好地入门Python爬虫,开启你的爬虫之旅!

其他相关扩展阅读资料参考文献:

基础概念

- 爬虫是指通过程序自动化获取互联网上的公开数据,通常用于数据采集、信息分析等场景,其核心是模拟浏览器行为,解析网页内容并提取所需数据。

- 合法性是爬虫开发的前提,根据《计算机信息网络国际联网安全保护管理办法》,爬虫需遵守网站robots.txt规则,不得对服务器造成过载,且仅限于获取公开信息。

- 基本流程包括发送HTTP请求、解析响应内容、提取数据、存储结果四个步骤,使用requests库获取网页,用BeautifulSoup解析HTML,再将数据保存为CSV或数据库。

核心工具与技术

- Requests库是Python中最常用的HTTP请求工具,支持GET、POST等方法,能快速获取网页内容。

response = requests.get('https://example.com')。 - BeautifulSoup擅长解析静态网页,可提取HTML标签中的文本、链接等信息,其优势在于语法简洁,适合小规模数据抓取。

- Selenium用于处理动态加载的网页,通过模拟浏览器操作(如点击、滚动)实现完整页面渲染,适用于需要JavaScript交互的网站,如电商页面或社交平台。

- Scrapy框架是专业级爬虫工具,提供爬虫、中间件、管道等模块,支持分布式爬取和数据清洗,适合大规模项目。

- Playwright作为新兴工具,支持多浏览器(Chrome、Firefox等)自动化,能处理复杂的前端交互和反爬机制,适合现代网页爬取。

实战应用技巧

- 模拟浏览器指纹:通过设置User-Agent、随机延迟、使用代理IP等手段,避免被网站识别为爬虫,用

headers={'User-Agent': 'Mozilla/5.0'}伪装浏览器。 - 应对反爬策略:部分网站会限制请求频率或要求登录,需使用Cookie池、验证码识别工具(如OCR)或模拟登录流程,通过

requests.Session()保持登录状态。 - 处理动态内容:对于依赖JavaScript的网页,Selenium或Playwright能渲染页面,提取隐藏数据(如评论、广告),使用Playwright等待元素加载后提取。

- 数据存储优化:爬取数据后需选择合适格式,如JSON、CSV或数据库,对于结构化数据,可使用SQLite或MongoDB;非结构化数据则适合存储为文件。

- 分布式爬取:Scrapy-Redis等工具支持多节点协作,可提升效率并避免单点IP被封,将爬虫任务分发到多个服务器同时运行。

进阶开发方向

- 数据清洗与处理:使用Pandas或正则表达式去除无效信息,如重复内容、特殊符号,用

pd.DataFrame().drop_duplicates()清理数据。 - API接口调用:部分网站提供开放API,直接调用比爬取网页更高效且稳定,通过

requests.get('https://api.example.com/data')获取结构化数据。 - 构建爬虫集群:结合消息队列(如RabbitMQ)和任务调度(如Celery),实现自动化、可扩展的爬虫系统,将任务分发到多个工作节点并行处理。

- 监控与日志:为爬虫添加异常捕获和日志记录功能,便于排查问题,使用

logging.info()记录爬取进度,try-except处理网络错误。 - 法律与伦理边界:爬虫需遵守《数据安全法》和《个人信息保护法》,避免抓取敏感信息或侵犯用户隐私,不得爬取用户登录后的个人数据。

常见问题与解决方案

- IP被封禁:使用付费代理IP服务或IP池技术,轮换IP地址以降低风险,通过

proxies={'http': 'http://10.10.1.10:8080'}设置代理。 - 验证码识别:利用第三方服务(如云打码)或训练深度学习模型,破解滑块、文字等验证码,用

pyotp处理TOTP验证码。 - 网页结构变化:定期更新解析逻辑,或使用XPath、CSS选择器动态适配页面元素,用

lxml库灵活定位节点。 - 数据存储冲突:设计合理的数据库表结构,避免字段类型错误或主键重复,使用UUID作为唯一标识符。

- 性能瓶颈:通过异步请求(如aiohttp)或并发线程(如concurrent.futures)提升爬取速度,使用

asyncio.gather()同时发起多个请求。

:Python爬虫技术门槛较低,但需兼顾效率、合规性与稳定性,初学者可从requests和BeautifulSoup入手,进阶者则需掌握Scrapy或Playwright等工具,并关注反爬策略和数据处理优化。爬虫的本质是技术与规则的平衡,只有合法合规地使用,才能在数据挖掘与自动化任务中发挥最大价值。

“python 爬虫,Python爬虫实战技巧与案例分析” 的相关文章

bootstrap方法总结,Bootstrap常用方法与技巧概览

Bootstrap方法是一种用于估计统计模型参数的方法,通过从样本中反复抽取子样本,并构建多个模型来估计参数,其核心思想是利用多次抽样的结果来估计参数的分布,Bootstrap方法适用于大多数统计模型,可以用于参数估计、置信区间构建、假设检验等,其优点是无需复杂的数学推导,计算简单,适用于大数据分析...

c语言代码格式,C语言代码规范与格式指南

本文介绍了C语言代码的格式规范,包括源文件的基本结构、注释的添加、变量和函数的命名规则、代码缩进和空白字符的使用等,强调良好的代码格式对于提高代码可读性和维护性至关重要,并提供了具体的格式化建议,如每行代码不超过80个字符,使用空格和制表符合理缩进,以及适当使用注释来解释代码功能。C语言代码格式:规...

excel函数公式教学,Excel函数与公式实战教程

本教程旨在帮助您掌握Excel函数公式的使用,我们将从基础知识入手,介绍如何使用公式进行数据计算、分析和管理,涵盖常用函数如SUM、AVERAGE、VLOOKUP等,并通过实际案例演示公式的应用,学习完成后,您将能够熟练运用Excel公式解决日常工作中的数据处理问题。Excel函数公式教学:轻松掌握...

mysql官网安装教程,MySQL官方安装指南

MySQL官网安装教程摘要:,本教程详细介绍了如何在您的系统上安装MySQL数据库,访问MySQL官网下载最新版本的安装包,根据您的操作系统选择相应的安装程序,按照安装向导的提示完成安装过程,包括配置数据库和设置用户权限,测试MySQL服务以确保其正常运行,教程中还包含了常见问题的解决方法,帮助您顺...

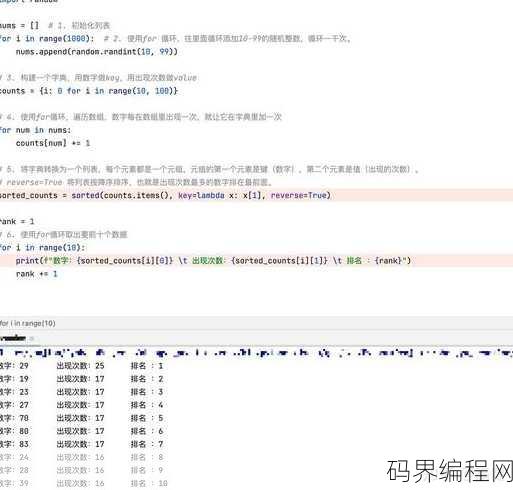

随机数函数python,Python实现随机数函数的技巧与代码示例

Python中的随机数函数主要用于生成不可预测的随机数,常用于密码学、模拟、游戏等领域,Python标准库中的random模块提供了多种随机数生成功能,random.random()生成[0.0, 1.0)区间内的随机浮点数;random.randint(a, b)生成[a, b]区间内的随机整数;...

不允许active控件怎么办,应对无Active控件挑战的策略

在无法使用active控件的情况下,可以采取以下几种方法:,1. 使用HTML和CSS:通过HTML标签和CSS样式来创建交互式元素,如按钮、表单等,以替代active控件的功能。,2. JavaScript辅助:利用JavaScript添加事件监听器,实现与active控件相似的功能,如点击、拖动...