网站源码采集,高效网站源码采集攻略

网站源码采集主要指的是通过技术手段获取网站的全部或部分源代码,这个过程通常用于分析网站结构、功能实现、前端设计等,以便于逆向工程、学习编程技巧或进行安全评估,采集方法包括手动下载、使用浏览器开发者工具、编写脚本自动化抓取等,在进行源码采集时,需注意遵守相关法律法规和网站的使用条款,尊重版权和隐私。

揭秘网络信息获取的奥秘

用户解答: 嗨,我最近在做一个项目,需要从某个网站上采集一些数据,但是我对网站源码采集这个话题不太了解,请问,网站源码采集是什么?怎么进行呢?

网站源码采集的介绍

-

什么是网站源码采集? 网站源码采集,顾名思义,就是获取网站页面的原始代码,这些代码包含了网站的结构、样式和功能,是网站内容的基础。

-

为什么要进行网站源码采集?

- 数据获取:通过采集网站源码,可以快速获取网站上的信息,如文章、图片、视频等。

- 功能分析:了解网站的功能实现方式,有助于开发类似功能的网站。

- 安全性评估:通过分析网站源码,可以发现潜在的安全漏洞。

-

网站源码采集的合法性 在进行网站源码采集时,必须遵守相关法律法规,不得侵犯网站版权和隐私。

网站源码采集方法

-

手动采集

- 浏览器开发者工具:使用Chrome、Firefox等浏览器的开发者工具,可以查看和修改网页源码。

- 文本编辑器:使用Notepad++、Sublime Text等文本编辑器,可以打开和编辑网页源码。

-

自动化采集

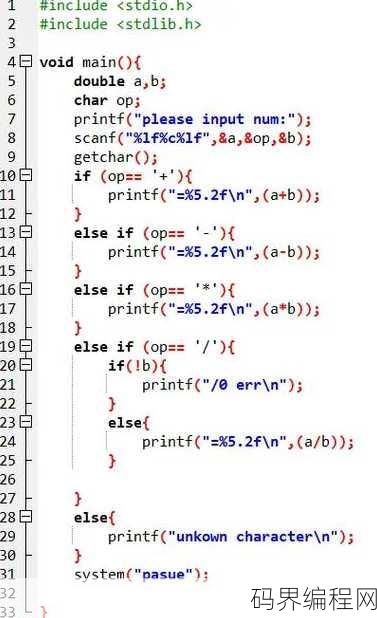

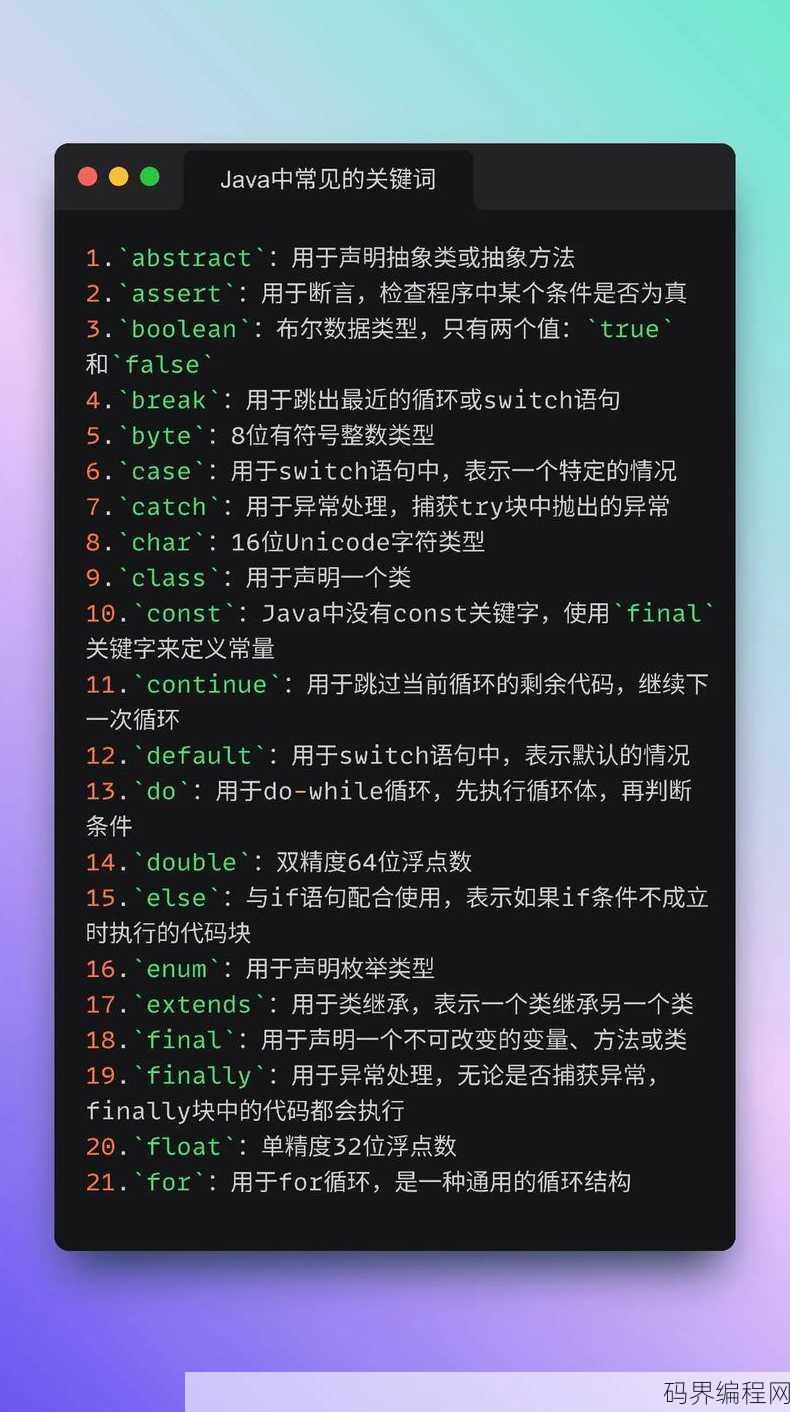

- 网络爬虫:使用Python、Java等编程语言,编写爬虫程序自动采集网站源码。

- 在线工具:使用在线网站源码采集工具,如Octoparse、BeautifulSoup等。

网站源码采集注意事项

-

避免过度采集 过度采集可能导致网站服务器压力过大,甚至被网站封禁。

-

尊重网站版权 在采集网站源码时,不得侵犯网站版权,不得用于非法用途。

-

数据安全 在采集过程中,注意保护用户隐私和数据安全。

网站源码采集案例分析

-

案例分析:采集电商网站商品信息

- 采集目标:获取商品名称、价格、图片等基本信息。

- 采集方法:使用Python编写爬虫程序,采集网站源码中的商品信息。

- 注意事项:遵守网站版权,避免过度采集。

-

案例分析:采集新闻网站文章内容

- 采集目标:获取文章标题、作者、发布时间、内容等。

- 采集方法:使用网络爬虫工具,如Octoparse,采集网站源码中的文章信息。

- 注意事项:尊重网站版权,避免过度采集。

网站源码采集的未来发展趋势

-

技术发展 随着人工智能、大数据等技术的发展,网站源码采集技术将更加智能化、高效化。

-

法律法规完善 随着网络信息安全的日益重视,相关法律法规将不断完善,规范网站源码采集行为。

-

伦理道德约束 在进行网站源码采集时,应遵循伦理道德,尊重网站版权和用户隐私。

网站源码采集是一项具有广泛应用的技术,但在进行采集时,必须遵守法律法规,尊重网站版权和用户隐私,随着技术的不断发展,网站源码采集将在未来发挥更大的作用。

其他相关扩展阅读资料参考文献:

技术原理

-

数据采集的核心在于模拟用户行为

网站源码采集的本质是通过程序模拟人类访问网页的过程,获取服务器返回的HTML、CSS、JavaScript等原始代码,这一过程需要发送HTTP请求,解析响应内容,并提取目标数据,采集工具会伪装成浏览器,避免被服务器识别为爬虫。 -

反爬虫机制应对是关键难点

现代网站普遍采用验证码、IP封锁、请求频率限制等反爬措施,采集时需通过动态User-Agent切换、请求头伪造、模拟点击行为等方式绕过限制,若遇到验证码,可借助第三方OCR服务或人工干预。 -

数据清洗与存储需精准高效

采集到的源码通常包含冗余信息(如广告、空白标签),需通过正则表达式或XPath解析提取结构化数据,并存储至数据库或本地文件,存储时需注意数据格式标准化,避免因编码问题导致解析失败。

应用场景

-

市场分析与竞品研究

企业可通过采集竞品网站的源码,分析页面布局、功能模块、用户交互设计等,为产品优化提供参考,采集电商平台的商品详情页,提取价格、评价、库存等数据用于动态定价策略。 整合与二次开发**

开发者可采集目标网站的源码作为参考模板,用于开发类似功能的系统,采集新闻网站的栏目结构,复用其导航逻辑快速搭建内容管理系统,节省开发时间成本。 -

SEO优化与流量监控

采集搜索引擎结果页(SERP)的源码,可分析关键词布局、页面权重等SEO指标,通过采集网站流量数据,监控竞争对手的访问量变化,调整自身推广策略。 -

数据迁移与系统升级

当企业需更换网站平台时,可采集旧系统的源码作为迁移依据,将传统静态网站内容采集后导入新框架,确保数据完整性与结构一致性。 -

学术研究与行业报告

研究人员可通过采集公开网站的源码,分析技术趋势(如前端框架使用率)、用户行为模式等,采集社交媒体平台的源码,研究用户生成内容的分布规律。

法律风险

-

未经授权采集可能构成侵权

根据《著作权法》,网站源码属于受保护的计算机软件,若未获得授权,采集并二次使用可能面临版权纠纷,采集某电商平台的源码用于商业开发,需与原权利人签订协议。 -

数据合规需遵循地域性法规

欧盟GDPR、中国《个人信息保护法》等法规对数据采集有严格限制,采集涉及用户个人信息的网站源码时,需确保数据匿名化处理,并取得用户明确同意。 -

隐私保护是采集的底线

若源码包含用户登录信息、敏感数据等,采集行为可能违反隐私条款,采集某论坛的用户发帖数据时,需过滤掉个人身份信息(PII),避免数据泄露风险。 -

服务条款中的禁止性规定

多数网站在用户协议中明确禁止自动化采集行为,若违反条款,可能被封禁IP或追究违约责任,采集某视频网站的源码时,需规避其“禁止爬虫”的robots.txt规则。 -

法律责任可能涉及赔偿

若采集行为导致网站服务器过载或数据篡改,可能面临民事或刑事责任,大规模采集某政府网站源码引发系统崩溃,需承担相应的修复与赔偿义务。

工具与方法

-

Python是主流采集语言

使用requests库发送HTTP请求,BeautifulSoup或lxml解析HTML,pandas处理数据,Python的灵活性与丰富的库支持,使其成为源码采集的首选工具。 -

Selenium适合动态网页采集

对于依赖JavaScript渲染的网页(如电商详情页),需用Selenium模拟浏览器操作,其优势在于能执行点击、表单提交等交互动作,但缺点是资源消耗大,需优化脚本效率。 -

Scrapy框架提升采集效率

Scrapy是专为爬虫设计的Python框架,支持异步处理与分布式部署,通过定义Spider类,可高效采集大规模网站源码,同时内置去重机制降低冗余数据。 -

代理IP与请求头优化

频繁请求易触发IP封锁,需通过代理IP池分散访问压力,设置合理的请求头(如User-Agent、Referer)可提高请求成功率,避免被服务器直接拦截。 -

分布式爬虫应对高并发需求

对于需采集大量页面的场景(如全网数据抓取),可使用Scrapy-Redis或分布式框架(如Apache Nutch)实现多节点协作,需注意负载均衡与任务分发策略,避免单点过载。

实践案例

-

电商价格监控系统

通过采集多个电商平台的源码,提取商品价格与库存信息,实时比对并推送优惠通知,需处理动态加载的JavaScript内容,并应对平台的反爬策略。 -

新闻聚合平台开发

采集主流新闻网站的源码,提取标题、发布时间等数据,整合至统一平台,需关注版权问题,优先选择开放授权的新闻源,或通过API合法获取数据。 -

企业官网数据迁移

将旧版官网的源码采集后导入新版系统,保留原有内容结构与功能模块,需验证数据完整性,确保CSS样式与JavaScript逻辑在新环境中兼容运行。 -

社交媒体舆情分析

采集微博、知乎等平台的源码,提取用户评论与互动数据,用于情感分析与热点追踪,需注意数据脱敏,避免涉及用户隐私的敏感信息。 -

行业报告数据采集

通过采集行业论坛、技术博客的源码,提取专业术语与案例数据,生成市场趋势报告,需结合自然语言处理技术,自动识别关键信息并分类存储。

网站源码采集是一项技术与法律并重的实践,需在合法合规的前提下,结合高效工具与合理策略实现目标,无论是企业数据应用还是个人技术探索,明确采集边界、规避风险隐患始终是核心,随着技术迭代,采集方式将更趋智能化,但对伦理与法律的敬畏不可缺失。

“网站源码采集,高效网站源码采集攻略” 的相关文章

源程序文件是什么意思,源程序文件的定义与解读

源程序文件,通常指的是包含计算机程序原始代码的文件,这些代码是由程序员使用编程语言编写的,用于指导计算机执行特定任务,源程序文件不直接执行,需要通过编译器或解释器将其转换为机器码或字节码,才能被计算机理解并执行,C语言源程序文件以.c为扩展名,而Python的源程序文件则以.py 嗨,我最近在学习...

input 只读,探索只读输入的奥秘与应用

中未包含具体信息,因此我无法为您生成摘要,请提供具体内容,以便我为您制作摘要。用户提问:我最近在使用一个网页表单时发现有一个“input 只读”的选项,我不太明白这是什么意思,能给我解释一下吗? 解答:当然可以,在网页表单设计中,“input 只读”是一个功能选项,它允许你将某个输入框设置为只读状...

java编程需要什么软件,Java编程必备软件清单

Java编程需要以下软件:1. Java开发工具包(JDK):提供Java运行时环境、编译器、库等;2. 集成开发环境(IDE):如Eclipse、IntelliJ IDEA等,提供代码编辑、调试、运行等功能;3. 文本编辑器:如Notepad++、Sublime Text等,用于编写和编辑Java...

计算机代码经典编程,计算机代码,经典编程宝典

计算机代码经典编程主要涉及对计算机程序设计语言的深入研究与实践,通过学习经典编程案例,可以掌握编程基础,提高算法设计与实现能力,经典编程还包括对经典算法、数据结构以及设计模式的深入学习,旨在培养编程思维和解决问题的能力。计算机代码经典编程——探寻编程之美 用户解答: 大家好,我是编程新手小王,最...

beanpole钱包,Beanpole钱包,轻便与安全并重的数字资产管理利器

Beanpole钱包是一款注重隐私保护的钱包,采用多重加密技术确保用户资产安全,它支持多种数字货币,操作简单,界面友好,Beanpole钱包致力于为用户提供便捷、安全的数字资产管理服务。解析Beanpole钱包:你的数字资产管理利器 大家好,我是小王,一个对数字货币充满热情的投资者,我发现了一个非...

高中导数的基本公式14个,高中导数核心公式,14个必掌握的基本公式解析

高中导数的基本公式包括:,1. 常数函数的导数:\( f(x) = c \) 的导数 \( f'(x) = 0 \),2. 幂函数的导数:\( f(x) = x^n \) 的导数 \( f'(x) = nx^{n-1} \),3. 正弦函数的导数:\( f(x) = \sin x \) 的导数 \(...