如何编写爬虫程序,轻松入门,编写高效爬虫程序全攻略

编写爬虫程序涉及以下几个步骤:选择合适的编程语言,如Python;确定目标网站,了解其结构;使用如requests库发送HTTP请求获取页面内容;解析HTML内容,提取所需数据;存储数据,可选择数据库或文件,注意遵守网站爬虫协议,尊重版权。

你好,我最近想学习如何编写爬虫程序,但感觉有点无从下手,你能给我一些入门的建议吗?

当然可以,编写爬虫程序其实可以分为几个关键步骤,下面我会从几个来详细讲解,希望能帮助你入门。

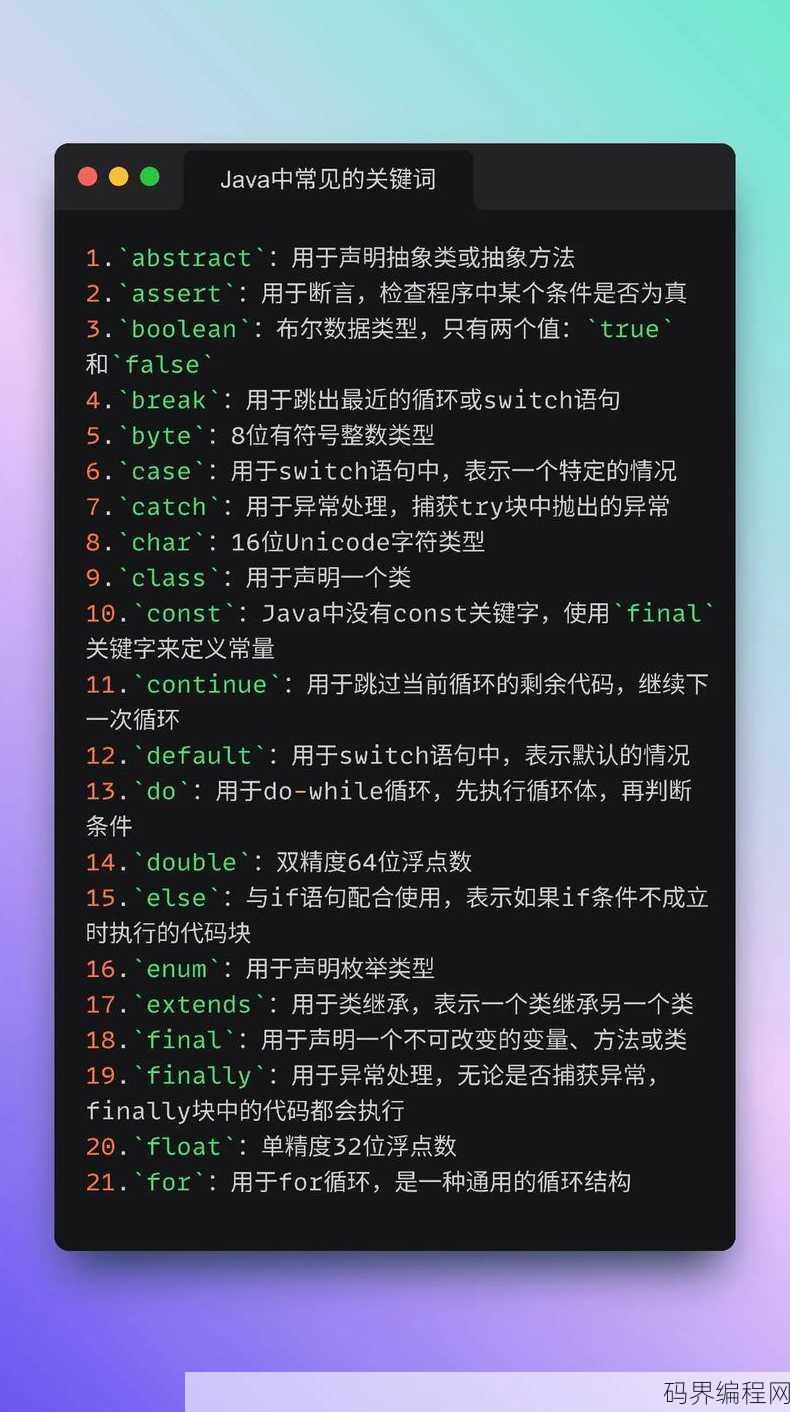

一:选择合适的爬虫框架

- 了解常见框架:市面上有很多优秀的爬虫框架,如Python的Scrapy、BeautifulSoup、Selenium等。

- Scrapy的优势:Scrapy是一个高效、易于使用的爬虫框架,它提供了丰富的功能,如自动处理请求、下载、解析等。

- BeautifulSoup的选择:如果你需要处理HTML和XML文件,BeautifulSoup是一个很好的选择,它提供了强大的解析功能。

- Selenium的适用场景:Selenium适合需要模拟浏览器行为,如登录、点击等操作的爬虫任务。

- 框架对比:选择框架时,要考虑你的需求、学习成本和项目复杂度。

二:了解目标网站的结构

- 分析网站结构:在编写爬虫之前,首先要了解目标网站的结构,包括URL规则、页面布局、数据存储方式等。

- 使用工具:可以使用开发者工具来分析网站结构,如Chrome的“检查”功能。

- 数据分布:注意数据在网站中的分布,有些数据可能分布在不同的页面或通过API获取。

- 数据格式:了解数据的格式,如JSON、XML或HTML。

- 反爬策略:注意目标网站可能有的反爬策略,如IP封禁、验证码等。

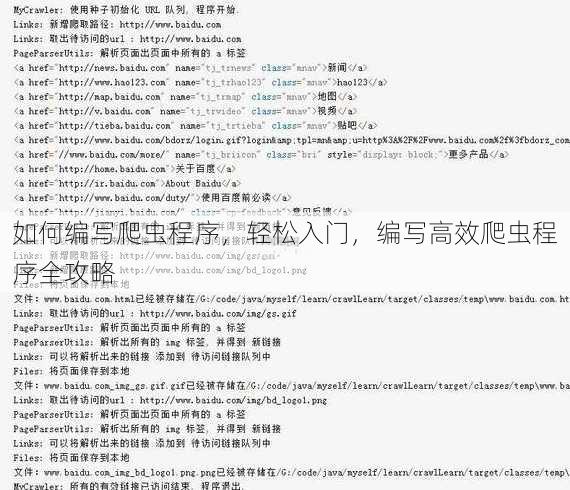

三:编写爬虫代码

- 安装依赖:根据选择的框架,安装必要的依赖库。

- 设置爬虫配置:配置爬虫的基本参数,如允许的域名、请求延迟等。

- 编写解析逻辑:根据目标网站的结构,编写解析逻辑来提取所需数据。

- 存储数据:选择合适的数据存储方式,如CSV、数据库等。

- 错误处理:编写错误处理逻辑,确保爬虫在遇到问题时能够正确处理。

四:遵守法律法规和道德规范

- 了解相关法律:在编写爬虫之前,要了解相关的法律法规,如《中华人民共和国网络安全法》。

- 尊重版权:不要爬取受版权保护的内容。

- 遵守robots.txt:大多数网站都提供了robots.txt文件,说明哪些页面可以爬取,哪些不可以。

- 保护个人隐私:不要爬取个人隐私信息。

- 避免滥用:不要使用爬虫进行恶意行为,如批量发送垃圾邮件。

五:优化和扩展

- 提高效率:优化爬虫代码,提高数据提取效率。

- 分布式爬虫:对于大型网站,可以考虑使用分布式爬虫来提高效率。

- 日志记录:记录爬虫的运行日志,方便排查问题。

- 持续更新:网站结构可能会发生变化,要定期更新爬虫代码。

- 监控和反馈:监控爬虫的运行状态,及时处理异常情况。

通过以上几个的讲解,相信你已经对如何编写爬虫程序有了初步的了解,编写爬虫程序需要耐心和细心,多实践,多总结,才能不断提高自己的技能,祝你学习顺利!

其他相关扩展阅读资料参考文献:

明确爬虫目标与合法性

- 确定需求范围:在编写爬虫前,需清晰界定目标网站、数据类型和采集频率,若需抓取电商商品信息,需明确目标平台(如京东、淘宝)、商品分类、数据字段(价格、评价、库存)及是否需要定时更新。

- 遵守robots协议:通过查看目标网站的robots.txt文件,确认是否允许爬虫访问,若协议禁止爬取,切勿强行操作,否则可能被封禁或面临法律风险。

- 法律合规审查:确保爬虫行为符合《计算机信息网络国际联网安全保护管理办法》等法规,避免侵犯网站版权或用户隐私。数据使用需获得授权,尤其涉及敏感信息时。

选择合适的工具与技术栈

- Python为核心语言:Python的requests库用于发送HTTP请求,BeautifulSoup或lxml处理HTML解析,Scrapy构建完整爬虫框架,是主流选择。

- 掌握基础库功能:requests支持GET/POST请求,可设置headers模拟浏览器;BeautifulSoup提供直观的DOM树操作,适合静态网页;lxml则以速度著称,适合大规模数据处理。

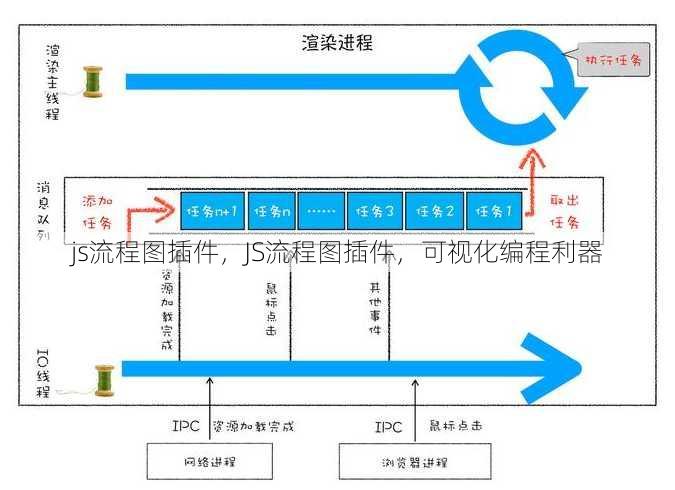

- 考虑异步与分布式:若需高并发采集,使用aiohttp(异步HTTP库)或Celery(分布式任务队列)可提升效率;Scrapy-Redis支持分布式爬虫,适合处理复杂爬取任务。

- 其他语言备选:Java(Jsoup)、Node.js(Puppeteer)或Go(Gocolly)也可用于爬虫开发,但Python因生态丰富、学习成本低更受推荐。

设计数据采集与解析流程

- 解析HTML结构:通过BeautifulSoup的

find()或select()方法定位目标标签,例如<div class="gjqaerjgeihgjdfbba8f-394d-e32b-dc29 price">提取商品价格,需注意标签嵌套与动态加载问题。 - 处理JSON数据:若目标网站返回JSON格式数据(如API接口),使用Python的

json.loads()直接解析,可避免复杂的HTML解析步骤。 - 正则表达式匹配:对于非结构化文本,使用re模块编写正则规则提取关键信息,如

<span class="gjqaerjgeihgjdfb394d-e32b-dc29-2d17 title">.*?</span>匹配商品标题,但需警惕HTML结构变动导致的匹配失败。 - XPath与CSS选择器:XPath适合复杂层级的精准定位,CSS选择器则更简洁直观。

//div[@class='gjqaerjgeihgjdfb6b91-b4db-b283-ba8f product']//span[@class='gjqaerjgeihgjdfbb4db-b283-ba8f-394d price']可提取特定商品价格字段。 - 处理:若网站使用JavaScript渲染内容(如Vue/React框架),需借助Selenium或Playwright模拟浏览器行为,避免直接解析静态HTML。

应对反爬机制与技术挑战

- 设置请求头模拟浏览器:在requests中添加

headers={'User-Agent': 'Mozilla/5.0'},伪造浏览器标识以绕过简单的IP检测。 - 使用代理IP池:通过代理服务器轮换IP地址,避免因频繁请求被目标网站封禁,可使用免费代理(如快代理)或付费服务(如IPIDEA)提高稳定性。

- 处理验证码与登录验证:对于需要登录的网站,使用Session对象保持登录状态;若遇到验证码,需借助第三方服务(如打码平台)或OCR技术识别,避免直接暴力破解。

- 设置请求延迟与并发控制:通过

time.sleep()或Scrapy的DOWNLOAD_DELAY参数控制请求频率,防止因高并发触发反爬策略。 - 模拟用户行为:添加随机请求头、模拟点击事件或使用Headless浏览器(如Chrome无头模式)提升爬虫拟真度,降低被识别为机器人的概率。

优化数据存储与后续处理

- 选择合适数据库:结构化数据(如MySQL、PostgreSQL)适合存储表格型信息;非结构化数据(如MongoDB)适合处理JSON或文本;CSV文件便于快速导出与分析。

- 数据清洗与标准化:使用Pandas库对采集数据进行去重、格式转换(如日期标准化)和缺失值处理,确保数据质量。

- 建立数据索引与分页机制:对大规模数据,设计数据库索引提升查询效率;通过模拟分页参数(如

page=1、page=2)逐页抓取,避免一次性请求过多内容。 - 日志记录与异常处理:在爬虫中添加日志模块(如logging)记录请求状态,使用try-except捕获异常(如网络错误、解析失败),确保程序稳定性。

- 自动化与监控系统:通过定时任务(如cron)或任务调度器(如Airflow)实现爬虫自动化;设置监控报警(如邮件通知)及时发现数据异常或封禁风险。

实战案例与常见问题解决

- 电商商品数据抓取:以京东为例,分析商品列表页结构,定位商品ID、名称、价格等字段,使用Scrapy框架构建爬虫,定期更新商品信息。

- 社交媒体动态抓取:针对微博、知乎等平台,需处理动态加载内容(如通过Selenium模拟滚动),并注意反爬策略(如限制请求频率)。

- 数据存储优化:对于高频更新数据,采用Redis缓存临时结果;对于低频数据,使用MySQL分表存储以提升查询效率。

- 反爬策略升级:若遭遇IP封禁,可切换代理服务器或使用分布式爬虫;若网站采用IP黑白名单,需通过付费代理服务规避。

- 法律风险规避:在采集数据前,通过邮件或官网联系目标网站获取授权;若数据涉及个人隐私,需匿名化处理(如去除用户ID)并加密存储。

编写爬虫程序需兼顾技术实现与合规性,核心在于理解目标网站结构、选择合适工具、优化数据处理流程,初学者应从简单静态网页入手,逐步掌握动态内容处理与反爬策略;进阶者需关注分布式架构与自动化运维,无论技术难度如何,始终牢记法律底线,避免因违规操作导致严重后果,通过持续学习与实践,爬虫技术可成为数据挖掘与信息分析的高效工具。

“如何编写爬虫程序,轻松入门,编写高效爬虫程序全攻略” 的相关文章

css背景图,CSS背景图应用与技巧解析

CSS背景图是网页设计中常用的一种元素,通过CSS代码可以设置网页元素的背景图片,它支持多种图片格式,如jpg、png、gif等,并且可以设置图片的重复、定位、尺寸等属性,使用CSS背景图可以丰富网页视觉效果,提升用户体验。CSS背景图的使用技巧与奥秘 用户提问:嗨,我想了解一下CSS背景图的使用...

bootstrap方法总结,Bootstrap常用方法与技巧概览

Bootstrap方法是一种用于估计统计模型参数的方法,通过从样本中反复抽取子样本,并构建多个模型来估计参数,其核心思想是利用多次抽样的结果来估计参数的分布,Bootstrap方法适用于大多数统计模型,可以用于参数估计、置信区间构建、假设检验等,其优点是无需复杂的数学推导,计算简单,适用于大数据分析...

java手机游戏合集,Java手游精选集

《Java手机游戏合集》是一款集合了多款经典Java手机游戏的软件,该合集包含了多种类型的游戏,如益智、动作、冒险等,旨在为用户提供丰富的游戏体验,用户可以通过这款软件在手机上重温经典,享受轻松愉快的游戏时光,合集支持多种Java手机平台,操作简便,是怀旧玩家和游戏爱好者的不二之选。用户提问:大家好...

个人导航网页源码,个性化个人导航网页源码揭秘

个人导航网页源码是一种可自定义的网页代码,用于创建个人专属的导航页面,它通常包含用户喜欢的网站链接、搜索框以及个性化设计元素,源码可以方便地集成到个人网站或博客中,帮助用户快速访问常用资源,提高浏览效率,用户可以根据自己的需求修改和定制源码,以适应不同的界面风格和功能需求。 嗨,我最近在寻找一个个...

绝世剑神林辰全文免费,绝世剑神林辰,剑道巅峰免费全文

《绝世剑神林辰》是一部免费小说,讲述了主角林辰从平凡少年成长为绝世剑神的传奇故事,林辰在修炼剑道的过程中,历经磨难,凭借过人的天赋和坚定的信念,最终站在了剑道的巅峰,这部小说以精彩的打斗场面和丰富的情感描写,吸引了众多读者。 “绝世剑神林辰全文免费”,这名字听起来就让人热血沸腾!我最近迷上了这本小...

七牛云价格,七牛云存储价格大揭秘

七牛云提供灵活多样的价格策略,包括按量付费、预付费和资源包等多种计费模式,用户可根据实际需求选择合适的付费方式,享受高效、经济的云存储和计算服务,具体价格因所选服务和配置不同而有所差异,建议用户根据自身业务需求,访问七牛云官网详细了解并选择最合适的方案。深度解析七牛云的性价比与优势 作为一名长期使...